1. 기초 수학 및 프로그래밍

1.1 선형대수 기초 (벡터, 행렬 연산, 내적, 전치 등)

1.2 미분/적분 (연쇄법칙, 극값, 최적화 관련)

1.3 확률과 통계 (기대값, 분산, 확률분포, 베이즈 정리 등)

1.4 파이썬 기초 (변수, 함수, 제어문 등)

1.5 NumPy, Pandas, Matplotlib 사용법

추천 도서:

- 『밑바닥부터 시작하는 딥러닝 1』

- 『Linear Algebra and Learning from Data』

추천 강의:

2. 머신러닝 기초

2.1 지도학습: 선형회귀, 로지스틱 회귀

2.2 비지도학습: K-Means, PCA

2.3 과적합과 일반화

2.4 정규화 (L1/L2), Dropout

2.5 모델 성능 평가 지표 (Accuracy, Precision, Recall, F1 등)

추천 도서:

- 『핸즈온 머신러닝 2판』

추천 강의:

3. 딥러닝 기초

3.1 퍼셉트론과 다층 신경망

3.2 순전파와 역전파 개념

3.3 손실 함수 (MSE, CrossEntropy 등)

3.4 옵티마이저 (SGD, Adam 등)

3.5 활성화 함수 (Sigmoid, ReLU, Tanh 등)

추천 도서:

- 『딥러닝 입문』

- 『Deep Learning by Goodfellow』

추천 강의:

4. 주요 딥러닝 아키텍처

4.1 CNN (Convolutional Neural Network)

4.1.1 필터, 스트라이드, 패딩 개념

4.1.2 Max Pooling, Flatten

4.2 RNN (Recurrent Neural Network)

4.2.1 순환 구조

4.2.2 LSTM, GRU

4.3 Transformer 구조 이해

4.3.1 Attention, Multi-head Attention

4.3.2 Positional Encoding

4.3.3 Encoder-Decoder 구조

추천 도서:

- 『밑바닥부터 시작하는 딥러닝 2』

추천 강의:

5. 프레임워크 실습 및 미니 프로젝트

5.1 PyTorch 기초

5.1.1 Dataset, DataLoader

5.1.2 nn.Module과 Model 구성

5.1.3 학습 루프 구성 (train, eval loop)

5.2 TensorFlow 기초

5.2.1 Keras API 사용

5.2.2 모델 저장 및 로드

5.3 기본 프로젝트

5.3.1 MNIST 손글씨 분류

5.3.2 CIFAR-10 이미지 분류

5.3.3 간단한 감성 분석 모델

추천 도서:

- 『파이토치 첫걸음』

추천 강의:

6. 실무 응용 분야

6.1 자연어 처리(NLP)

6.1.1 토큰화, 임베딩

6.1.2 RNN 기반 텍스트 처리

6.1.3 BERT, GPT 등 사전학습 모델

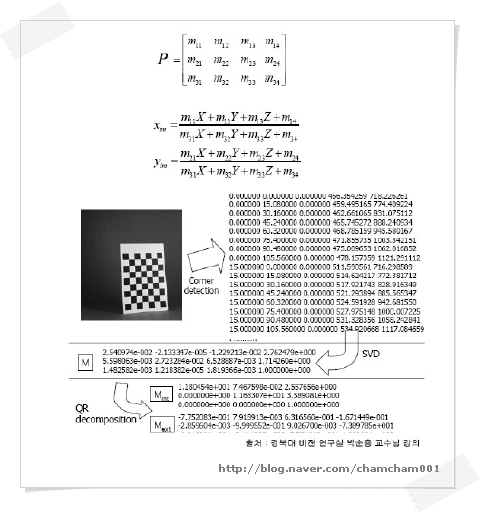

6.2 컴퓨터 비전

6.2.1 Object Detection: YOLO

6.2.2 Semantic Segmentation: U-Net

6.3 강화 학습

6.3.1 Q-Learning

6.3.2 Policy Gradient

6.3.3 Deep Q-Network(DQN)

추천 도서:

- 『딥러닝을 이용한 자연어 처리 입문』

- 『Deep Reinforcement Learning Hands-On』

추천 강의:

7. 생성형 AI (Generative AI)

7.1 AutoEncoder / Variational AutoEncoder (VAE)

7.2 GAN (Generative Adversarial Networks)

7.2.1 Generator vs Discriminator

7.2.2 DCGAN, StyleGAN

7.3 Diffusion Models

7.3.1 Stable Diffusion, Denoising

7.4 Transformer 기반 생성 모델

7.4.1 GPT-2, GPT-3 구조

7.4.2 텍스트, 이미지, 음성 생성

7.5 ChatGPT 및 LLM 응용 사례

추천 도서:

- 『GANs in Action』

- 『The Deep Learning Revolution』

추천 강의:

📌 부록

- 실습 플랫폼: Google Colab, Kaggle

- 논문과 코드: Papers with Code

- 추가 추천: fast.ai, DeepLearning.ai